《科创板日报》8 月 24 日讯 (记者 张洋洋)国产大模型企业 DeepSeek「点燃」 资本市场。

近日,DeepSeek 宣布其新一代模型 DeepSeek-V3.1 采用了 UE8M0 FP8 Scale 参数精度,并明确指出该精度标准是针对即将发布的下一代国产芯片设计。这一消息迅速在资本市场引发强烈反应,寒武纪等芯片类上市企业股价集体拉升。

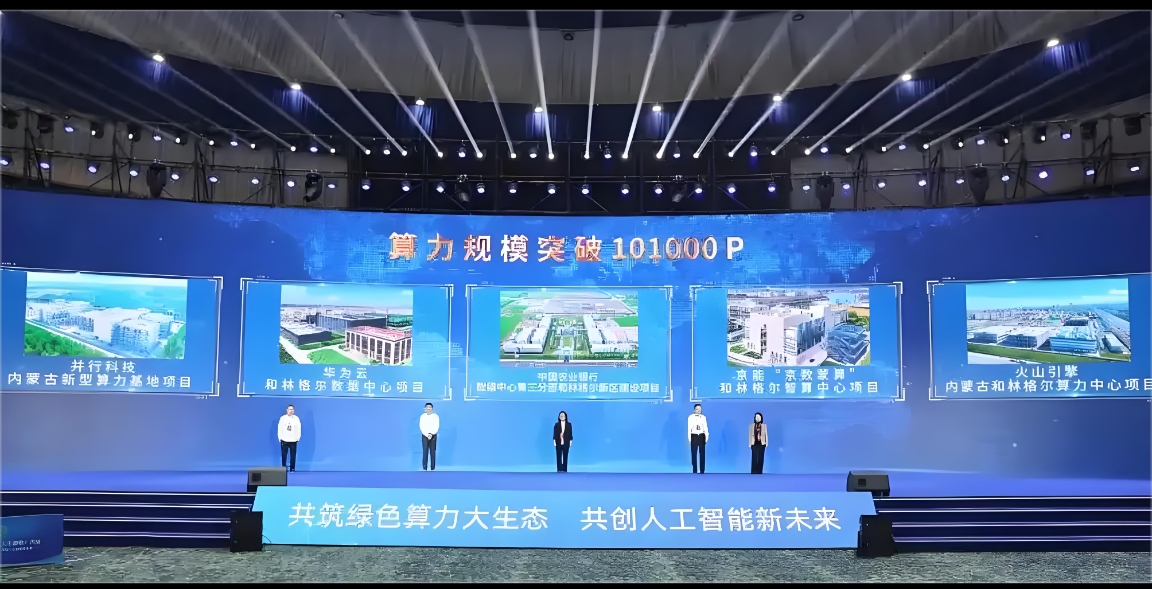

不过,在近两日举办的 2025 算力大会上,据 《科创板日报》 记者的现场采访和观察来看,大家在聚焦国产算力时,DeepSeek 的 FP8 精度标准虽被讨论,但业内人士的情绪显然没有资本市场那么高亢。技术派更关注 FP8 在模型训练、推理及生态标准化上的实际价值与挑战。

▍FP8 是什么,有哪些提升?

在 AI 训练与推理过程中,为提升计算效率,数值精度的降低是一个常见的技术路径。

摩尔线程 AI Infra 总监陈志向 《科创板日报》 记者称,过去,大模型训练推理普遍使用 FP32(32 位浮点数),随后逐步过渡到 FP16(16 位浮点数) 混合精度,以减少存储和通信开销,FP8 则进一步将数据宽度压缩至 8 位。

「FP8 最直接的优势是算力效率翻倍,另一个好处是降低降低训练和推理过程中网络带宽的通信量。」 陈志称,比如原本传输一个 FP32 数值需 4 字节,现在仅需 FP8 仅需要 1 字节,虽然网络物理带宽本身未必扩大,但单位时间内可传输信息是增加的,同时也让存储要求降低。这意味着在相同功耗下,AI 芯片可训练更大的模型或缩短训练时间。

不过,FP8 也不是万能的。

在 2025 算力大会现场,另一名不愿具名的国产芯片厂商从业人员告诉 《科创板日报》 记者,用类似 FP8 低精度训练推理虽然快,但也容易因数值范围太小导致计算出错。而且,不同计算对精度要求不同,像矩阵乘法这类操作对精度不敏感,可以用较低的精度 (如 FP8) 计算;而像累加或某些函数则需要较高精度。因此,业内通常采用 「混合精度训练」,根据计算类型动态选择不同的精度,兼顾效率与准确。

▍Deepseek 能否推动新标准

DeepSeek-V3.1 使用 UE8M0 FP8 Scale 的参数精度,被视为国产 AI 芯片即将迈入新阶段的信号。受此刺激,寒武纪等芯片类上市公司股价大幅上涨,但产业界人士态度更为审慎。

在业内看来,DeepSeek 此举无疑给了国内算力厂商的机会,FP8 代表了算力优化的正确方向,大模型训练推理不只是堆砌硬件,但它也并非 「灵丹妙药」,更需要关注的是实际落地效果。此外 DeepSeek 的这一动作,后续是否会成为大模型训练与推理的新标准。

在陈志看来,大模型对精度的容忍度越来越高,从 FP32 到 FP16,再到 FP8,是整个行业逐步验证过的路径。DeepSeek 这次验证了 FP8 在大规模模型上的可行性,未来在 FP8 这一标准乃至更高精度上去做研究或者做训练也是一个很重要的方向。

当然,这一趋势也意味着,国产算力生态需要同步升级,包括芯片、框架、算力平台到应用层的闭环适配。

陈志表示,精度标准一旦变化,上下游厂商也需要联动优化。摩尔线程已提前布局 FP8 研究,既是技术储备,也是为了在生态调整中占据主动。

他进一步说到,大模型训练推理的核心瓶颈不仅是算力规模,还包括能耗、稳定性和集群利用,「国内万卡规模集群已有部署,但还要向大智算集群演进,解决效率与容错问题,确保集群可靠性。简单 『堆卡』 并不能完全满足需求,提高单卡效率与集群调度优化同样关键」。