自 9 月 OpenAI 发布全新 AI 推理大模型 GPT-o1 后,国内企业机构也开始了密集的更新,同步到推理模型的进程。

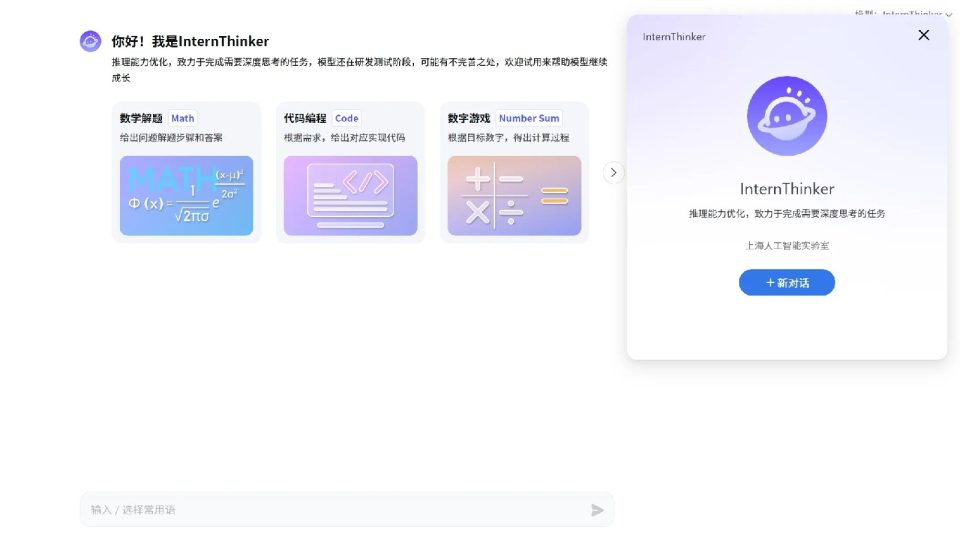

11 月 25 日晚,上海人工智能实验室向社会用户开放了书生·浦语大模型,并在大模型界面发布了强推理模型 InternThinker。据悉,InternThinker 模型具有长思维能力,并能在推理过程中进行反思和纠正,从而在数学、代码、推理谜题等多种复杂推理任务上取得更优结果。

这个月已有多个推理模型的发布。11 月 16 日,月之暗面 Kimi 宣布推出新一代数学推理模型 k0-math,号称数学能力对标 OpenAI o1 系列。11 月 20 日,DeepSeek 发布推理模型 DeepSeek-R1-Lite,称模型通过强化学习训练,在数学、代码和复杂逻辑推理任务上表现媲美 o1-preview。

发布推理模型已成当前 AI 行业的一大趋势,上海人工智能实验室青年科学家陈恺在接受第一财经采访时表示,「目前大模型的头部机构都有研发和发布推理模型的计划,因为推理能力是大模型智能水平的重要体现,也是面向复杂应用场景的必备能力。」

强大的推理能力是迈向通用人工智能的重要基础。从应用层面来看,陈恺认为,模型推理能力的进一步提升将会带来更多的智能应用场景,可以和人更好地协作进行思考和解决高难度任务,从而推动大模型在生产力方面的应用。

在具体应用上,陈恺举例表示,一般的大模型可以在读完一份财报之后帮忙整理其中的关键信息,如果是具备强推理能力的模型,未来就可以像分析师一样帮助分析财报中的数据,给出合理的研究和预测。

在提升模型推理能力方面,陈恺提到,目前主要的难点是高密度监督数据,例如高难度的问题和更详细的思维链,这些数据在自然文本中占比很小,需要研究有效的构造方法。此外,推理能力目前的提升路径依赖有效的强化学习,在强化学习中如何提升模型的搜索效率,如何训练泛化且可靠的奖励模型以便于获取反馈也是难点。

OpenAI 9 月发布的 o1 模型展示出强大的推理能力,在提升模型推理能力的研究中,据介绍,实验室采用的是相对独立的路线,通过设计元动作思考范式来引导模型的搜索空间,基于通专融合的方式进行数据合成,并通过构建大规模沙盒环境获取反馈,从而提升模型的性能。

具体来说,人在学习解决复杂推理任务时,并非从海量的样本中进行单点知识的学习,而是思维模式的学习——在解决问题的过程中,通过回忆相关知识点,对正确的解题过程进行理解、记忆,对错误解题等过程进行反思和修正,即对自我的认知过程进行觉察和调节,该能力也被称作元认知能力。

受元认知理论的启发,实验室的研究团队设计了一系列元动作来引导模型解决问题的过程,如对问题的理解、知识回忆、规划、执行、总结等。模型在面对复杂任务时,会显式且动态地选择元动作,再进一步展开相关动作的具体思维过程。通过这种设计,利用部分训练任务,可强化模型对关键元动作组合的使用,提升模型学习效率。

随着大模型的不断发展,陈恺认为,目前行业的研究方向从按照 Scaling Law(尺度定律) 简单地放大模型参数量和数据,转向了更多样化的探索。他预测,未来一部分资源投入会从预训练转向后训练,包括使用更多的推理算力来换取模型更好的性能,以及强化学习的大规模应用。

此前在发布推理模型时,谈及 Scaling Law 是否还有效,月之暗面 Kimi 创始人兼 CEO 杨植麟也提到了 Scaling law 的范式转换,他认为,过去大模型的路径是 「next token prediction」,但预测下一个词有局限性,是一个静态的数据集,没办法探索更难的任务,接下来大模型的目标是通过强化学习让 AI 具备思考的能力。

「接下来还能持续 scale,只是过程不一样。」 杨植麟认为,预训练还有半代到一代模型的空间,这个空间可能会在明年释放出来,但是他判断,接下来最重点的还是强化学习。