文章来源:techweb

【旭才科技】10 月 14 日消息,今天凌晨,蚂蚁集团正式推出万亿参数思考模型 Ring-1T,并全面开源模型权重、训练配方。

Ring-1T 在 9 月 30 日开源的预览版 Ring-1T-preview 基础上,持续扩展大规模可验证奖励强化学习 (RLVR) 训练,进一步激发万亿基座的自然语言推理能力,并通过 RLHF 训练完善模型通用能力,在各项任务榜单上表现更加均衡。

为了持续激发 Ring-1T 的数学等复杂推理能力,此次百灵团队挑战了难度更高的 IMO2025(国际数学奥利匹克) 赛题,将 Ring-1T 接入多智能体框架 AWorld,使用纯自然语言推理进行解题。实验结果显示,Ring-1T 仅用一次解出了第 1、3、4、5 题,相当于 IMO 银牌水平,成为首个能拿 IMO 国际奥数奖的开源系统。Ring-1T 在第三次尝试 IMO 时对第 2 题几何证明也给出了接近满分的证明过程,在顶流大模型几乎全军覆没的第六题中将答案收敛到与 Gemini 2.5 Pro 相同的 「4048」(正确答案为 2112)。

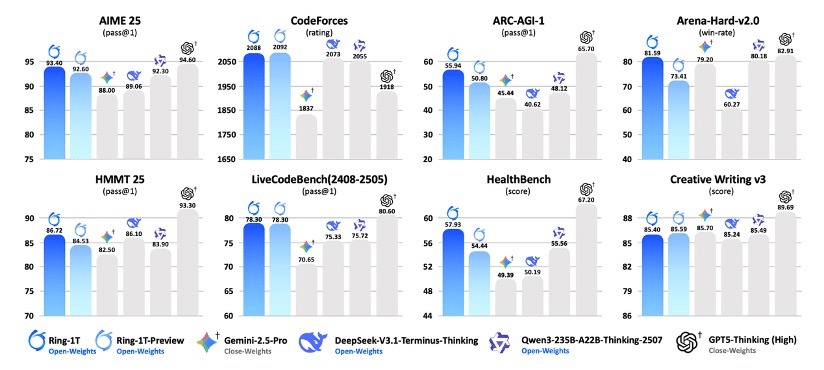

作为一款思考模型,Ring-1T 也表现出了很好的通用能力,在 「人类偏好对齐」 测试 Arena-Hard V2 中,Ring-1T 以 81.59 的成功率居于开源模型榜首,逼近 GPT-5-Thinking(High)82.91 的成绩。在面向严谨领域的医疗问答 HealthBench 测评中,Ring-1T 也以最高分取得开源领域最佳。

万亿参数思考模型训练最大难题是训推精度差异,即训练阶段与推理阶段因实现细节差异导致的训练和推理精度不一致,进而导致训练崩溃。据介绍,在 Ring-1T 模型中,蚂蚁采用了自研的 「棒冰 (icepop)」 算法来应对这项行业难题,即用带掩码的双向截断技术把训练-推理分布差异冻结在低水位,确保长序列、长周期训练不崩。

此外,应对万亿参数模型强化学习训练,蚂蚁还自研了高性能强化学习系统 ASystem(其中包含已开源的高性能强化学习框架 AReaL),特别针对万亿参数模型的显存管理和训推权重交换问题做了精细的优化,实现了单机显存碎片秒级回收、权重零冗余交换,把大规模 RL 训练稳定跑成日常。

据百灵团队透露,Ring-1T 模型是其在万亿思考模型上的首次尝试,蚂蚁百灵团队会在后续的版本中继续完善模型性能。目前,用户可通过 HuggingFace、魔搭社区下载模型,并通过蚂蚁百宝箱等平台在线体验。

最近,百灵团队动作频频,先是 9 月 30 日发布了 Ring-1T 的预览版 Ring-1T-preview,二者都是思考模型,也就是推理模型。10 月 9 日,蚂蚁集团发布了万亿参数通用大语言模型 Ling-1T,这个是非思考模型。

截至目前,蚂蚁百灵大模型已经发布 18 款模型,形成从 160 亿总参数到 1 万亿总参数的大语言模型产品矩阵,其中包括两款万亿参数模型:通用大语言模型 Ling-1T、思考模型 Ring-1T。